In immer mehr Bereichen der Arbeitswelt – in Unternehmen ebenso wie im öffentlichen Sektor – werden Algorithmen zur Entscheidungsunterstützung eingesetzt. Diese Entwicklung wirft Fragen bezüglich der Verantwortung für die getroffenen Entscheidungen auf. Wer ist verantwortlich, wenn Algorithmen entscheiden: der Sachbearbeiter, die Programmiererin, die Führungskraft? Und was, wenn dies unklar bleibt oder niemand Verantwortung übernimmt?

Neue Technik, neue Probleme

Gerade in großen Unternehmen kann die automatisierte Datenverarbeitung eine große Arbeitserleichterung bedeuten. Algorithmen werden z. B. immer öfter dazu verwendet, Vorschläge für Entscheidungen zu machen. Sie unterstützen heute schon bei Entscheidungen über Einstellungen, Gehaltserhöhungen oder auch Kreditvergabe. Damit können aber auch neue Arten von Problemen einhergehen.

Wenn ein Algorithmus Fehler macht, ist oft unklar, wer dafür verantwortlich ist: Ist es die bzw. der Sachbearbeiter:in, die/der die Entscheidungsvorschläge des Algorithmus überprüfen soll, obwohl die Fälle immer mehr werden und die Zeit immer kürzer? Ist es die/der Techniker:in, die/der den Algorithmus entwickelt hat, aber die Arbeitsabläufe und Entscheidungskriterien nicht ausreichend kennt? Oder ist es die für die Einführung des Algorithmus letztverantwortliche Führungskraft? Werden diese Fragen im Betrieb nicht klar beantwortet, kann es dazu kommen, dass niemand für falsche Entscheidungen Verantwortung übernimmt und die Fehler im System nicht behoben werden. Diese Situation nennen wir „Verantwortungsvakuum“.

Probleme können auch auftreten, wenn Personen für die Entscheidungen des Algorithmus verantwortlich gemacht werden, obwohl sie den Algorithmus nicht genau verstehen: Sei es, weil sie nicht die dafür erforderliche Ausbildung haben, sei es, weil nicht transparent ist, wie der Algorithmus überhaupt funktioniert. Auch die Daten, auf deren Grundlage der Algorithmus arbeitet, müssen überprüfbar und gegebenenfalls korrigierbar sein.

Fehlerbehebung und Vertrauen ins System

Werden Fehler in Algorithmen nicht behoben, kann dies besonders große Auswirkungen haben. Schließlich werden diese Algorithmen oft für alle ähnlichen Entscheidungen in einer Organisation gleichermaßen eingesetzt. Ein Fehler im System kann daher mehr falsche Entscheidungen hervorrufen, als wenn Einzelpersonen (auch wiederholt) „händisch“ falsche Entscheidungen treffen. Dieser Effekt der Größenordnung wird auch dadurch noch verstärkt, dass den Entscheidungen von Algorithmen oft besonders stark vertraut wird. Um diese und andere Probleme zu vermeiden, muss die Einführung von Algorithmen durch bewusste Organisationsprozesse begleitet werden.

Worauf zu achten ist

Eine Hilfestellung für die genannten Probleme liefert der Leitfaden „Algorithmen in der Entscheidungsfindung – Leitfaden zu Verantwortlichkeit und Rechenschaft“, entwickelt im Rahmen eines Projekts der FH St. Pölten in Kooperation mit VICESSE, gefördert vom Digitalisierungsfonds Arbeit 4.0 der AK Wien. Darin wird die Problemlage im Zuge solcher Automatisierungsprojekte ausführlicher dargestellt, und verschiedene Aufgaben- und Verantwortungsbereiche werden zusammen mit den korrespondierenden Verantwortlichkeiten und Rechenschaftspflichten beschrieben.

Konkret sind dies die grundlegende Entscheidung über Einsatz/Abschaltung, die (organisationale) Implementierung, die (technische) Entwicklung, die Anwendung in der Praxis, die Systemsicherheit, die Datenverwaltung sowie die unabhängige Evaluierung. Die strukturierte Betrachtung der Aufgaben und Verantwortlichkeiten schafft überhaupt erst die Möglichkeit, Interessenkonflikte und Probleme durch die Verschiebung oder unzureichende Zuweisung von Verantwortung zu erkennen und rechtzeitig – idealerweise im Vorhinein – zu beheben.

Weiters ist auch ein zeitgerechtes Fehlermanagement wichtig – eine zentrale Rolle spielen hier formalisierte Feedback- und Kommunikationswege zwischen allen relevanten Akteur:innen. Dabei werden auch die wichtigsten datenschutzrechtlichen Aspekte sowie notwendige technische Voraussetzungen für die Übernahme persönlicher Verantwortung (wie Verständlichkeit, Transparenz oder ausreichende Dokumentation des Systems) miteinbezogen. Zuletzt enthält der Leitfaden eine Liste an thematisch gruppierten Leitfragen, die bei der bestmöglichen kritischen Reflexion zu den zentralen Problemkreisen helfen.

Algorithmen helfen Algorithmen

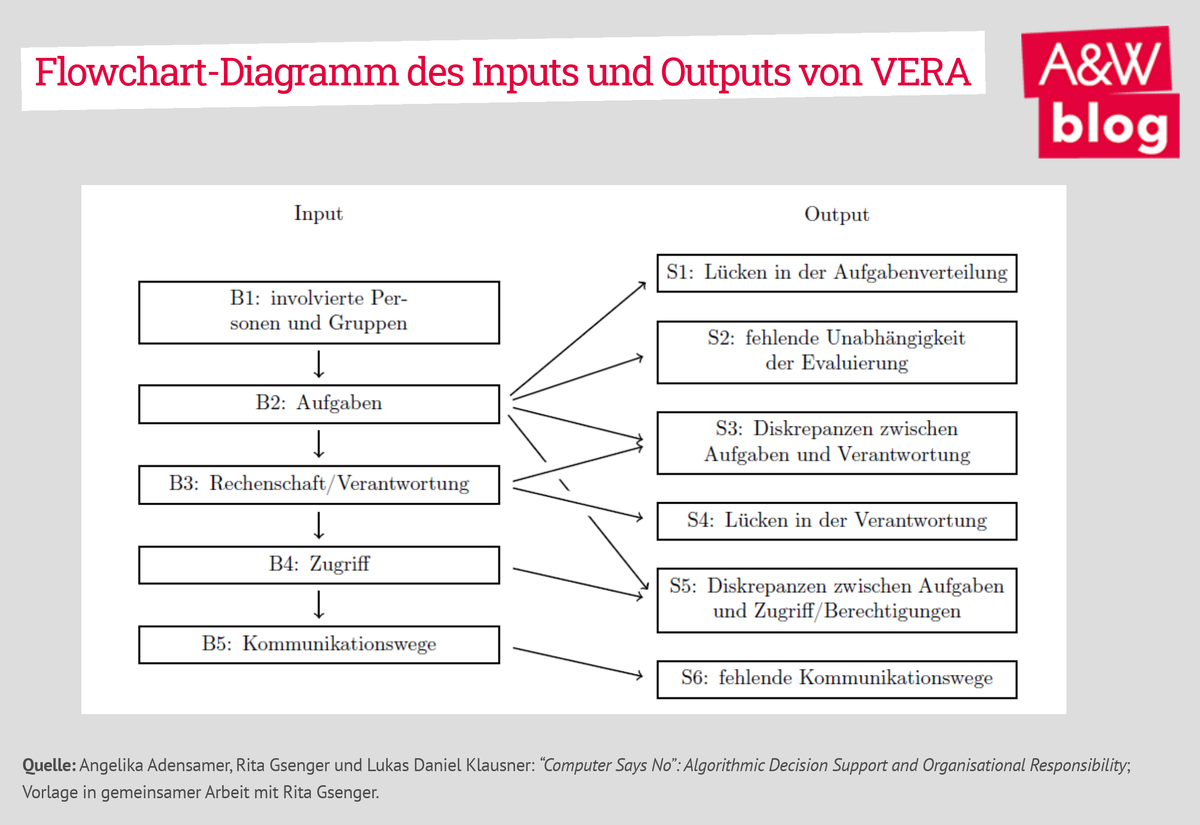

Ergänzend zum Leitfaden wurde im Rahmen des Projekts das digitale Tool VᴇʀA entwickelt. Dieses Tool soll insbesondere jene möglichen Probleme und Fallstricke aufzeigen, die sich aus den Hierarchien, Entscheidungsbefugnissen und Aufgaben in der Organisation ergeben. Das Ergebnis, das sich nach der Beantwortung einiger Fragen automatisch ergibt, liefert erste Hinweise und Ideen. Es ersetzt aber keine eigenständige Reflexion. Vielmehr ist es eine Hilfestellung, welchen Punkten jedenfalls Aufmerksamkeit gewidmet werden soll.

Ein Ergebnis kann z. B. sein, dass nicht alle Aufgaben, die bei einem algorithmischen System auftreten können (wie die Nachjustierung oder die Evaluierung), auch wirklich zugeteilt wurden. Somit könnte eine Lücke in Aufgaben oder Verantwortung bestehen. Auch kann es ein Problem darstellen, wenn die Person, die für einen Bereich Verantwortung trägt, in diesem keine Aufgaben hat oder nicht ausreichend Zugriffe und Berechtigungen, um das System anzupassen oder zu korrigieren. In diesen Fällen könnte es schwer oder unmöglich sein, die zugewiesene/übernommene Verantwortung wirklich wahrzunehmen. Schließlich werden auch fehlende Beschwerde- oder Feedbackwege innerhalb der Organisation als potenzielle Probleme erkannt.

Interessenvertretung im digitalen Zeitalter

Der Einsatz von Algorithmen kann für Arbeitnehmer:innen große Veränderungen in ihrer Arbeitsrealität bedeuten. Diese Veränderungen und die Probleme, die mit ihnen einhergehen, zu verstehen und zu benennen ist ein erster Schritt, um die Arbeitsbedingungen zu verbessern. Digitalisierung darf nicht dazu führen, dass Arbeitnehmer:innen für Fehler von Algorithmen verantwortlich gemacht werden, die sie weder verstehen noch verändern können. Für Arbeitnehmer:innen und ihre Vertretungen ist es daher wichtig, die Einführung von Algorithmen kritisch zu begleiten, ihre Resultate umfassend zu evaluieren und alle damit verbundenen Prozesse mitzugestalten. Der Leitfaden und das Tool VᴇʀA sind eine Hilfestellung für solche Aushandlungsprozesse.

Publikationen aus dem Projekt

- Angelika Adensamer und Lukas Daniel Klausner: “Part Man, Part Machine, All Cop”: Automation in Policing. Front. Artif. Intell. 4, 2021, doi: 10.3389/FRAI.2021.655486, arXiv:2106.12794 [cs.CY].

- Angelika Adensamer, Rita Gsenger und Lukas Daniel Klausner: “Computer Says No”: Algorithmic Decision Support and Organisational Responsibility. In Begutachtung.